AI-forordningen og compliance – hvem skal gøre hvad, og hvornår?

AI-forordningen blev vedtaget af Rådet d. 21/05/2024. Forordningen forventes nu offentliggjort i Den Europæiske Unions Tidende i løbet af juni/juli, hvorefter forordningens forbud træder i kraft 20 dage plus 6 måneder efter offentliggørelsesdatoen og reglerne for højrisikosystemer 18 måneder derefter. Forordningen bliver med andre ord til virkelighed om lidt. Vi vil i denne artikel gennemgå, hvilke compliancekrav forordningen påfører de forskellige typer virksomheder og omfanget af dem.

Denne artikel er én ud af flere artikler i vores artikelserie om AI-forordningen.

Udgivne artikler:

Kommende artikler

- Hvad betyder den ”risikobaserede tilgang” i AI-forordningen i virkelighedens verden?

Pligtsubjekter og sanktioner

AI-forordningen regulerer en række aktører på AI-markedet, men de to mest centrale er providers og deployers. Providers er dem, der udvikler et AI-system og placerer det på markedet, eller dem der udbyder systemet under sit eget navn eller varemærke – uanset om AI-systemet udbydes mod betaling eller ej. En deployer er en bruger af et AI-system i den forstand, at de udruller systemet til anvendelse, fx indkøber man en chatbot, som man stiller til rådighed for sine kunder, eller man får udviklet et system, man opsætter til lagerstyring. Den danske betegnelse for providers er udbydere. Den officielle danske betegnelse for deployers kendes ikke endnu, men den hidtidige betegnelse var brugere. Vi vil i denne artikel betegne providers som udbydere og deployers som brugere.

Forordningen opstiller en række nye – og i visse tilfælde store - krav til udbydere. De krav vil komme til at fylde meget i den almindelig debat om compliance alene i kraft af nyhedsværdien. Der er dog samtidig en række krav i forordningen, man som bruger skal være opmærksom på. Disse krav angår anvendelsen af AI-systemer. I den praktiske verden og mere almindelige erhvervsdebat vil der også være et stort fokus på kravene til brugere, fordi antallet af brugere af AI-systemer vil overstige antallet af udbydere af AI-systemer.

Manglende overholdelse af forordningens krav, uanset om man er udbyder eller bruger, kan udløse bøder på op til det højeste af 35 mio. euro eller 7 % af årlig global omsætning.

Som følge af en sen ændring i lovgivningsprocessen sondrer forordningen mellem AI-systemer og general purpose AI models (GPAI). AI-systemer er kendetegnet ved, at de selvstændigt kan generere outputs, såsom forudsigelser, indhold og anbefalinger. GPAI’er er større AI-modeller, såsom bl.a. ChatGPT og Copilot. GPAI’er er kendetegnet ved, at de kan bruges i mange forskellige sammenhænge, såsom at generere tekst, video og lyd, og at modellerne ikke er snævert afgrænset til ”bare” ét formål.

Vi vil her i artiklen fokusere på kravene til AI-systemer, dels fordi skaren af udbydere af GPAI’er er snæver, dels fordi brugerkravene til generiske AI-systemer er dækkende. Det interessante for langt de fleste vil blive afgrænsningen af roller og begreber, når GPAI’er anvendes i modificeret form – som er en almindelig ydelse hos flere GPAI-udbydere – nærmere end identificering og efterlevelsen af konkrete compliance krav.

Graden af compliance afhænger af AI-systemets kategorisering

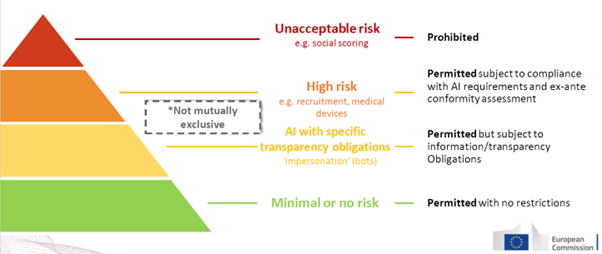

AI-forordningens krav til AI-systemer har en risikobaseret tilgang. Jo større risici, der er forbundet med systemet, jo flere forpligtelser skal overholdes. Europa-Kommissionen har illustreret de 4 kategorier af risici således:

- Unacceptable risk (forbudt praksis). Denne kategori inkluderer bl.a. AI-systemer, der bruges til social scoring som kendt fra Kina, og adfærdsforstyrrede AI-systemer, der kan forårsage skade på personer. Systemer, der anvendes til disse formål, må hverken udbydes eller anvendes med kun meget snævre undtagelser, der sigter til politi og efterretningstjenester.

- High risk (Højrisikosystemer). Højrisikosystemer er systemer, der udgør en risiko for fysiske personers sundhed, sikkerhed og grundrettigheder. AI-systemer, der bruges til bl.a. rekruttering- og ansættelsesprocesser, medicinsk udstyr, kritisk infrastruktur og visse essentielle offentlige ydelser og fordele, anses for at være højrisikosystemer, da disse kan forårsage alvorlige skadevirkninger, fx på fysiske personer og deres helbred, sikkerhed og grundrettigheder. Anvendes et AI-system eksempelvis til at grovsortere blandt patienter der skal modtage en organdonation, er der en risiko for, at systemet vægter forskellige vilkår, hvilket kan resultere i diskrimination baseret på usaglige hensyn. Det er derfor med forordningen bestemt, at disse systemer er underlagt særlig tung og omfattende regulering.

- Limited risk (Lavrisikosystemer). Lavrisikosystemer er fx AI-chatbots. Disse AI-systemer er underlagt informations- og transparenskrav. Denne slags systemer skal informere f.eks. kunden, der interagerer med systemet, om at de interagerer med et AI-system, og at systemets output, dvs. svar, er genereret af AI-systemet.

- Minimal risk (AI-systemer med minimal eller ingen risici). Dette er f.eks. AI-systemer, der bruges i spil, som derfor ikke medfører større (hvis nogen) risici for fysiske persons rettigheder. Disse er derfor ikke underlagt nogen regulering.

For bedst at illustrere forordningens krav til udbydere og brugere, så er det nedenstående struktureret med blik for højrisikosystemer, da disse er de mest omfattende, imens krav som dækker lavere klassificerede systemer bliver udpeget.

Fælles compliancekrav for udbydere og brugere

I den vedtagne tekst af forordningen er der indført et krav om AI-literacy. Kravet betyder, at udbydere og brugere, uanset risikokategoriseringen af AI-systemet, skal besidde de nødvendige færdigheder til at varetage deres opgaver, når de henholdsvis udvikler og bruger AI-systemer. Dette krav medfører, at man på sin arbejdsplads kan blive nødt til at implementere AI-politikker, awareness, do’s and don’ts osv. Jo større risici, der er forbundet med det pågældende AI-system, jo større grad af AI-færdigheder skal man besidde. Vi vil i vores næste artikel om AI-forordningens risikobaserede tilgang forklare, hvad en risikobaseret tilgang egentlig betyder i henhold til, hvordan man tilgår forordningens complianceforpligtelser.

Da reguleringen af AI er et nyt fænomen, findes der ikke omfattende retningslinjer, vejledninger og best practice på området endnu. Det følger af AI-forordningen, at der skal nedsættes et European Artificial Intelligence Board (EAIB), som bl.a. skal samle og udgive best practice for overholdelse af forordningen. EAIB er dog ikke oprettet endnu på tidspunktet for denne artikels udgivelsesdato.

Herhjemme i Danmark har visse myndigheder været på forkant med at udstede retningslinjer for AI. Digitaliseringsstyrelsen, der er blevet udvalgt som tilsynsmyndighed for AI-forordningen, har allerede udstedt guides, herunder om virksomheders og myndigheders brug af GPAI’er. Datatilsynet har i vejledninger også forholdt sig til brugen af AI, men disse har i det væsentligste været møntet på myndigheders udvikling og driften af AI-løsninger i et GDPR-regi. Der kommer uden tvivl til at blive udgivet flere vejledninger om forsvarlig brug af AI i henhold til AI-forordningen, men det er vores klare anbefaling, at man både som udbyder og bruger af et AI-system orienterer sig i de retningslinjer, der findes allerede nu.

Compliancekrav pålægges udbydere af højrisiko AI-systemer

Udbydere af højrisikosystemer er underlagt en lang række compliancekrav, der gælder både før og efter systemet udbydes på markedet og i systemets livscyklus. Kravene er de følgende med detaljerne til kravene uddybet nedenfor:

Compliance før højrisikosystemet udbydes på markedet:

- Data og data governance

- Tekniske krav og declaration of conformity

- Human oversight

- Quality management system

- Conformity assessment og CE-mærkning

- Registrering i en fælles EU-database

Compliance efter højrisikosystemet er udbudt på markedet og i systemets livscyklus:

- Risk management system

- Informations- og transparenskrav

- Løbende dokumentationsforpligtelser

- Post-market monitoring system

Compliance før højrisikosystemet udbydes på markedet:

Data and data governance

Udbydere er underlagt kravet om data and data governance. Inden en udbyder udvikler og udbyder et højrisikosystem, skal de sikre, at systemet er blevet oplært forsvarligt. Kravet indebærer, at træningsdata som højrisikosystemet oplæres i, skal have en vis kvalitet, så systemet oplæres på en forsvarlig og betroende måde. Det medfører blandt andet, at træningsdata i videst muligt omfang skal være fejlfri, så AI-systemet ikke bliver udsat for f.eks. data poisoning, der kan medføre skæve og forkerte outputs i forhold til systemets formål.

Særligt kravet om governance betyder, at udbydere skal organisere AI-systemets datastyring ud fra en hensigtsmæssig tilgang, der afspejler en forsvarlig og effektiv måde at oplære systemet på. Dette er eksempelvis ved at kunne overvåge, hvorvidt data kan resultere i bias ved systemets output, der har en negativ indvirkning på fysiske personers rettigheder, ved at have en overvægt af oplæringsdata, der uhensigtsmæssigt er rettet mod én bestemt målgruppe. Data governance medfører navnlig, at sådanne bias ikke opstår ved at sikre en effektiv styring af trænings- og oplæringsdata.

Tekniske krav og declaration of conformity

Udbydere af højrisikosystemer er underlagt en lang række tekniske krav. Forordningen medfører, at der skal laves en generel oversigt over systemets formål, hvordan systemet interagerer med hardware og software, herunder andre AI-systemer samt brugsinstruktioner til brugere, der skal bruge systemet.

Udbydere er også forpligtet til at holde en fortegnelse over AI-systemets design og dataindsamling tilgængelig. Systemet skal tilmed være designet, så systemet er teknisk sikkert og robust.

Udbydere skal også have udført en declaration of conformity, som skal beskrive, hvordan AI-systemet er compliant med kravene til højrisikosystemer. Udbyderne skal heraf kunne dokumentere, hvorfor højrisikosystemet er i overensstemmelse med forordningens compliancekrav, og hvordan systemet lever op til forordningens compliancekrav. Dette gøres ved at udfylde forordningens bilag V, som skal ligge til rådighed i et maskinlæsbart format for tilsynsmyndigheden ved anmodning herom, hvilket for Danmarks vedkommende vil sige Digitaliseringsstyrelsen.

Human oversight

Et højrisikosystem skal designes af en udbyder på en sådan måde, at en bruger kan overvåge systemet i perioden, systemet bruges. Det er på nuværende tidspunkt uklart i hvilket omfang, systemet skal overvåges. Det kan ikke udledes konkret af forordningens præambelbetragtninger, hvorvidt bestemmelsen medfører, at ethvert input og output skal overvåges af et menneske, eller om der alene er tale om en løbende forpligtelse til at foretage stikprøver af systemets drift.

Det vil være værd at tage den risikobaserede tilgang under overvejelse for nu, når man fastsætter behov for overvågningsgrad. Det vil i mangel af mere klar vejledning være mest oplagt at antage, at behovet afhænger af den potentielt indgribende effekt ved systemets funktion eller funktionsmåde.

Quality management system

Som udbyder af et højrisikosystem skal man have et quality management system (kvalitetsstyringssystem), der sikrer, at man overholder forordningens forpligtelser. Dette indebærer bl.a., man fører en fortegnelse over, hvordan man indsamler og behandler data til oplæring af AI-systemet, hvordan man kvalitetssikrer systemet, og hvordan man har indrettet systemet til at overholde forordningens dokumentationsforpligtelser. Systemet er i sin helhed møntet på at kunne dokumentere og bevise overholdelse af AI-forordningen.

Eksisterende kvalitetsstyringssystemer findes i en række regulerede sektorer, f.eks. hvor medicinaludstyr underlægges en lang række krav og specifikationer. Det vil derfor for visse udbydere være en genkendelig øvelse med et kvalitetsstyringssystem, hvorimod det for andre udbydere vil være nyt. En relevant øvelse bliver at finde balancen mellem at inkorporere krav under forordningen med eksisterende sektorspecifikke krav til kvalitetsstyringssystemerne.

Dokumentationen for kvalitetsstyringssystemet skal opbevares i 10 år.

Conformity assessment og CE-mærkning

Udbydere skal på baggrund af deres kvalitetsstyringssystemer lade højrisikosystemet undergå en conformity assessment, som kan udføres på flere måder.

Hvis udbyderen beviser og dokumenterer, at de følger harmoniserede standarder for compliance, kan de følge den lempeligere conformity assessment i forordningens bilag VI.Hvis udbyderen vurderer, at højrisikosystemet, forinden det udbydes på markedet, skal undergå en conformity assessment, men de ikke selv forsvarligt kan foretage en sådan vurdering, kan de lade en tredjepart foretage en sådan vurdering af systemet, hvilket i forordningens forstand er en conformity assessment body. Jo højere risiko, der er forbundet med systemet, desto højere er chancen for, at det skal vurderes af dette organ. Denne procedure følger forordningens bilag VII, hvor vurderingen er mere stringent end bilag VI.

Derudover skal udbydere af højrisikosystemer også påføres CE-mærkningen for at vise, at systemet overholder EU’s almindelige krav om sikkerhed, sundhed og miljøbeskyttelse.Registrering i en fælles EU-database

Forinden et højrisikosystem udbydes på markedet, skal visse højrisikosystemer registreres i en fælles EU-database. Brugere, der er myndigheder eller dem, der agerer på vegne af myndigheder, skal blandt andet registrere deres brug af højrisikosystemet på denne fælles database.

Sammenhængen med forordningens beskyttelse af IP og forretningshemmeligheder er relevant, men den nærmere balance mellem behov for registrering og fortrolighedshensyn er ikke detaljeret på nuværende tidspunkt af forordning eller myndighedsvejledning.

Compliance efter højrisikosystemet er udbudt på markedet og i systemets livscyklus

Risk management system

Udbydere skal i højrisikosystemets livstid have implementeret et risikostyringssystem, der systematisk kan overvåge systemet. Systemet skal bl.a. kunne identificere systemets iboende risici ved brugen af det og de eventuelle konsekvenser, og det skal også kunne vurdere, hvilke risici der måtte opstå, når systemet bruges i overensstemmelse med de dertilhørende brugsinstruktioner, som udbyderen selv har lavet. Højrisikosystemer skal i den anledning testes, for at det kan vurderes, om disse risici er til stede. Dette kan gøres i en regulatory sandbox, hvilket skal forstås som et testrum, hvor ens AI-system kan afprøves uden nærmere risici. Datatilsynet og Digitaliseringsstyrelsen lancerede denne tidligere på året, hvilket du kan se her.

Informations- og transparenskrav

Udbydere er underlagt en række informations- og transparensforpligtelser over for brugere af AI-systemet. Udbydere skal supplere højrisikosystemet med brugsinstruktioner, informationer om systemets tiltænkte formål, fortolkningsmetoder af systemets output mv. Udbydere skal også kunne påvise overholdelse af forordningen over for den nationale AI-tilsynsmyndighed, når denne anmoder om det. Dette minder om de tilsynsbesøg, som f.eks. Datatilsynet foretager i forhold til GDPR.

AI-forordningens compliance indebærer, at al compliance skal kunne dokumenteres. Det betyder, foruden de konkrete dokumentationsforpligtelser, at man som udbyder skal kunne dokumentere sin stillingtagen til, hvorfor man har indrettet sine sikkerhedsforanstaltninger, som man har, og hvilke risici man deraf mitigerer.Løbende dokumentationsforpligtelser

Udbydere skal opbevare automatisk genererede logs, som systemet har genereret, i mindst 6 måneder, medmindre andet fremgår af EU- eller national lovgivning.

Post-market monitoring system

Udbydere skal have et system, der iagttager og indsamler de relevante data i højrisikosystemets livstid, der bidrager til systemets fortsatte compliance med AI-forordningen.

Compliance som bruger

Brug i henhold til instruks

Som bruger er den vigtigste forpligtelse, at man efterlever instrukserne, som følger med højrisikosystemet, som udbyderen har givet. Det betyder fx, at man ikke må fodre et højrisikosystem med inputdata, der ikke er i overensstemmelse med det tiltænkte formål med systemet.

Human oversight som bruger

Brugere er forpligtet til at tildele ansvaret om at kunne iagttage forpligtelsen om human oversight til en fysisk person, der besidder de nødvendige kompetencer til at kunne iagttage denne opgave. De fornødne kompetencer kommer an på de omstændigheder og den kontekst, hvori højrisikosystemet bruges.

Notifikationskrav og hændelsesrapportering

Derudover skal brugere i overensstemmelse med de dertilhørende instrukser overvåge højrisikosystemet. Bliver man som bruger opmærksom på, at systemet udgør en risiko eller fare, selvom man efterlever udbyderens instrukser til systemet, er man forpligtet til at orientere udbyderen (eller distributøren) samt tilsynsmyndigheden, dvs. Digitaliseringsstyrelsen, og brugere skal derefter suspendere brugen af systemet.

Informationskrav

Der er krav om at informere sine kunder eller andre, når man som bruger har udrullet et AI system. Kravet gælder også for systemer med lavere risiko og transparenskrav og er et eksempel på at krav ikke er gensidigt uafhængige mellem højrisiko og systemer med lavere risiko med særlige transparenskrav.

Et eksempel på informationskravet er, hvor et højrisikosystem er anvendt på en arbejdsplads og arbejdspladsens ansatte bliver udsat for højrisikosystemets output, hvor arbejdspladsen er forpligtet til at orientere sine medarbejdere.Dokumentationskrav og logs

Hvis man som bruger har kontrol over de automatisk genererede logs, skal man som minimum opbevare disse i mindst 6 måneder, medmindre EU- eller national lovgivning tilskriver andet.

Er der særskilt regulering, fx for finansielle virksomheder?

I forordningen er der nu i langt de fleste compliancekrav ved højrisikosystemer tilføjet bestemmelser rettet særligt mod finansielle virksomheder. Når visse finansielle virksomheder rapporterer øvrig compliance over for fx Finanstilsynet, skal de samtidig rapportere deres compliance med AI-forordningen til dem. Dermed undgår finansielle virksomheder ”dobbeltcompliance” ved at skulle dokumentere og rapportere dokumentation for overholdelse af AI-forordningen til to forskellige myndigheder.

Måden, som disse finansielle virksomheder skal overholde forordningen på, er dog uændret. Det er præcis de samme krav, som vi har beskrevet ovenfor i afsnittet om compliance for udbydere, som finansielle virksomheder skal overholde. Det er usikkert om denne type mekanisme ved myndighedsvejledning eller på anden vis bliver udrullet til andre sektorer og industrier.

Hvornår skal man være compliant?

Forordningens ikrafttrædelsesdato er 20 dage efter offentliggørelsen i Den Europæiske Unions Tidende. Reguleringen vedrørende forbudt praksis finder anvendelse 6 måneder efter ikrafttrædelsesdatoen, reguleringen af GPAI finder anvendelse 12 måneder efter ikrafttrædelsesdatoen, og reguleringen af højrisikosystemer i medfør af forordningens bilag III finder anvendelse 24 måneder efter ikrafttrædelsesdatoen.

Vi hjælper allerede nu mange af vores klienter med at forberede sig på AI-forordningen.

Kontakt os, hvis du vil vide, hvordan AI-forordningen vil påvirke din virksomhed, og hvordan I kan forberede jer.